北京大学集成电路高精尖创新中心研究团队在模拟计算领域取得重要进展

2023/12/25 信息来源: 集成电路学院

编辑:安宁 | 责编:山石近日,北京大学集成电路学院、人工智能研究院、集成电路高精尖创新中心研究团队在《科学‧进展》(Science Advances)在线发表了题为《存内模拟计算一步求解压缩感知还原》(“In-memory analog solution of compressed sensing recovery in one step”)的研究论文。基于阻变存储器(忆阻器)阵列,该论文设计了一步实现矩阵-矩阵乘法的存内计算单元,并基于该单元设计了模拟计算电路,实现一步求解压缩感知还原算法。

压缩感知技术是现代信号、图像处理的基石,已被成功应用于医学成像、无线通信、目标追踪和单像素相机等重要领域。利用压缩感知理论,稀疏信号在前端传感器中可以实现高度欠采样,突破奈奎斯特采样定律,从而显著提升采样效率。在后端处理器中,通过求解稀疏近似问题,压缩感知信号可以得到还原。然而,压缩感知还原算法非常复杂,通常涉及高复杂度的矩阵计算和非线性元素操作,使得后端处理器还原过程成为了整个压缩感知流程中公认的瓶颈,限制了压缩感知技术在高速、实时信号处理场景中的应用。

为了加速压缩感知还原,在传统数字领域,要么通过使用深度学习等先进算法,要么通过设计高并行处理器。然而,计算效率仍然从根本上受到矩阵计算的多项式复杂度的限制。模拟计算具有固有的计算并行性,有望为解决该问题提供本质的加速。然而,同样地,由于压缩感知还原异常高的复杂性,此前的模拟计算方案依赖于三次方复杂度的矩阵-矩阵乘法预计算,或者需要迭代计算完成,产生频繁的数模和模数转换。因此,一步求解压缩感知还原仍然是一个巨大的挑战。

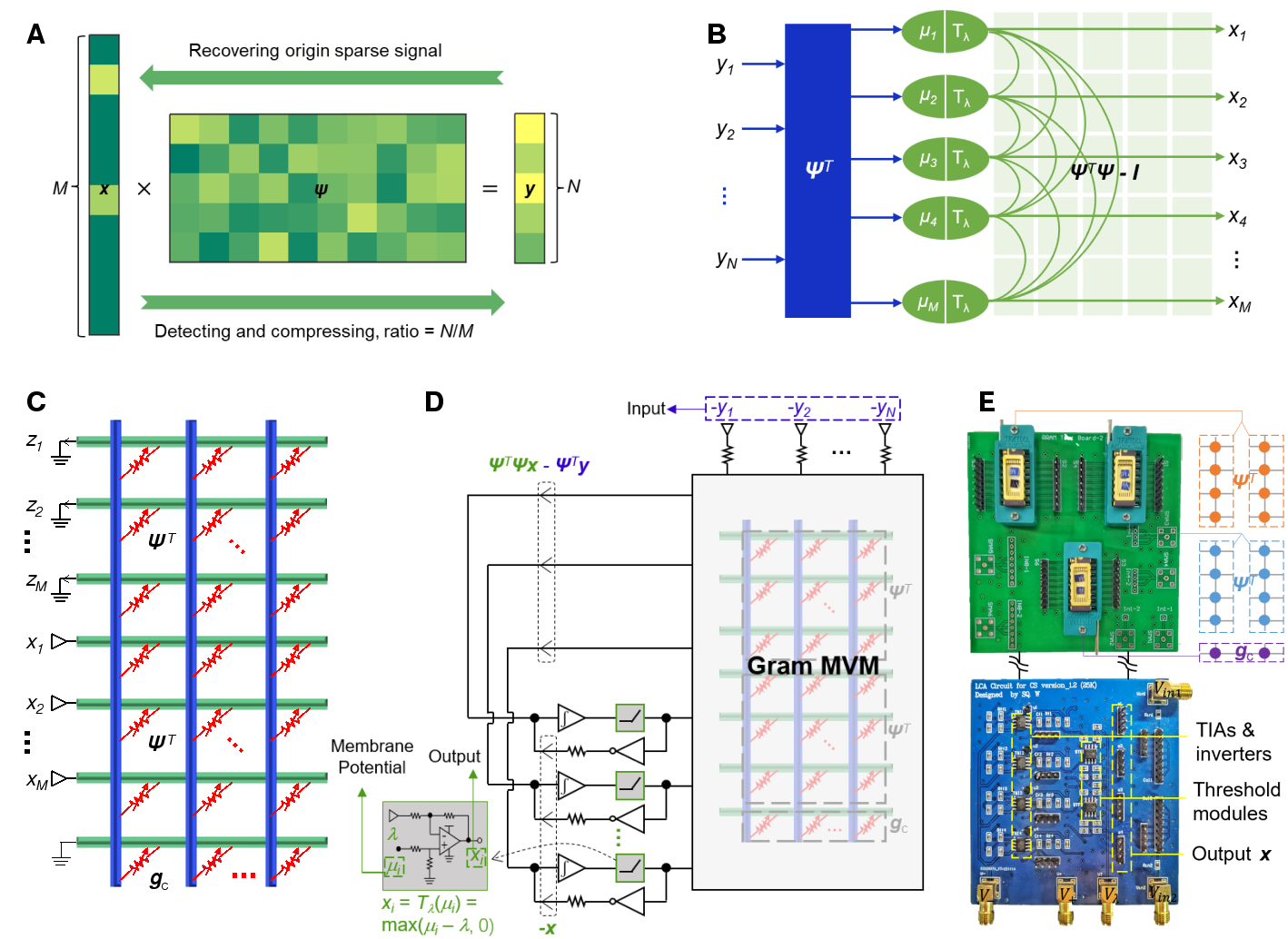

图1. MMVM和压缩感知还原电路示意图

为了解决该问题,研究团队首先设计了一种一步实现矩阵-矩阵-向量乘法(MMVM)的模拟存内计算单元,从而避免了矩阵乘法的预计算操作。进一步地,团队从求解的动力学方程出发,将该单元与其它模拟元件连接形成反馈回路,准确地映射了相应的算法,实现了无需预计算、无需迭代的一步求解压缩感知还原。

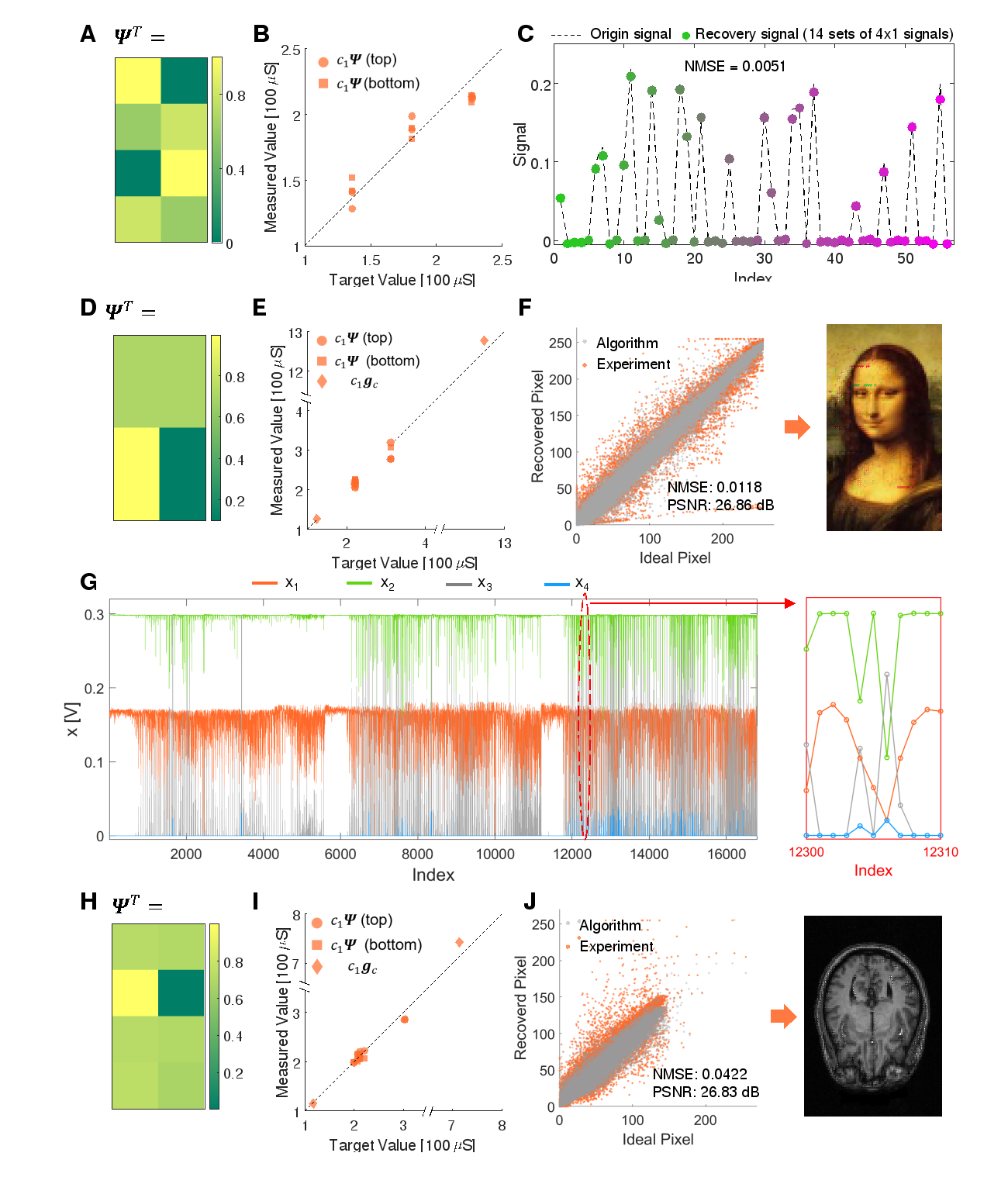

实验中,研究人员首先通过标准的半导体工艺制备了忆阻器阵列,并基于该阵列构建了设计的压缩感知还原电路。将压缩后的信息转化为电压信号输入到电路中,电路的输出端即可输出还原的原始信号。基于该电路,研究团队在实验中还原了一维稀疏信号、二维彩图和核磁共振影像(MRI),其归一化均值误差低达0.01,图片的峰值信噪比也达到了27dB。该电路的求解速度比深度学习等数字计算方法快1—2个数量级,同时也优于其它的电子或光子模拟计算方案。该电路为压缩感知终端设备的实时信号处理提供了一种全新的解决方案,有望促进实现先进的医疗、通信和图像处理技术。

图2. 一维信号、二维彩图和MRI还原实验结果

论文的第一作者是北京大学集成电路学院、人工智能研究院2021级博士研究生王识清,通讯作者是北京大学孙仲研究员,共同作者包括北京大学博士研究生罗宇标、左濮深、潘伦帅和李永祥。这项研究工作获得中国科技部、国家自然科学基金、111计划、集成电路高精尖创新中心等项目支持。

转载本网文章请注明出处